- 赛题名称:Comprehensive RAG Benchmark Challenge

- 赛题类型:大模型、RAG

- 赛题任务:基于搜索引擎和图片的RAG

AIcrowd | Meta Comprehensive RAG Benchmark: KDD Cup 2024 | Challenges

赛题背景

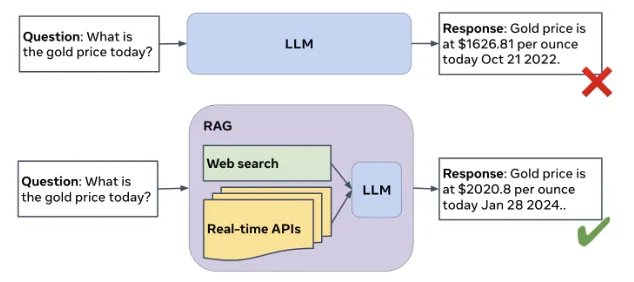

LLM(大型语言模型)基于AI代理可能出现幻觉性回应的频率取决于多种因素,包括训练数据中的偏见、缺乏上下文理解以及知识表示的限制。这些幻觉可能导致模型生成不准确或误导性信息。解决这一挑战对于确保LLM在提供准确信息方面的可信度至关重要。

为了提高LLM的准确性和可信度,可以考虑以下几种方法:

- 微调和校准:对LLM在特定领域或任务上进行微调可以提高其准确性并减少幻觉性回应。此外,校准模型以提供不确定性估计与回应可以帮助用户评估生成信息的可靠性。

- 外部知识整合:将外部知识源整合到LLM中可以帮助增强其理解能力并减少对幻觉性回应的依赖。检索增强生成(RAG)是一种利用外部资源提供有根据的答案的方法,从而提高生成响应的准确性。

尽管检索增强生成(RAG)具有潜力,但仍面临许多挑战,如选择最相关的信息来支撑答案、减少问答延迟和综合信息以回答复杂问题,这促使该领域的研究和开发工作。Meta Comprehensive RAG Challenge(CRAG)旨在提供一个具有清晰度量和评估协议的良好基准,以便对RAG系统进行严格评估、推动创新并推进解决方案的发展。

赛题任务

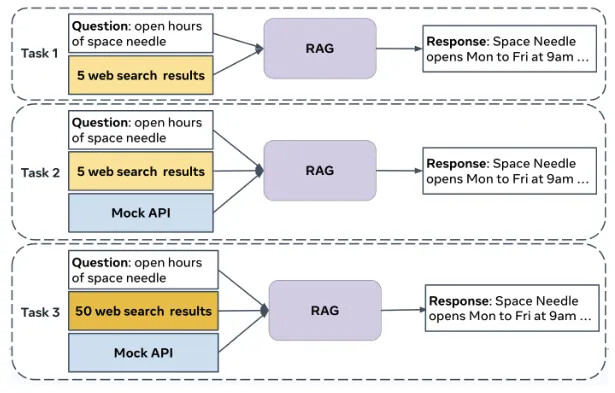

这个挑战包括三个旨在改进问答系统(QA)的任务。

任务1:基于Web的检索摘要

参与者每个问题收到5个网页,可能包含相关信息。目标是衡量系统将这些信息识别并概括为准确答案的能力。

任务2:知识图和Web增强

这项任务引入了模拟API,用于访问底层模拟知识图谱(KGs)中的信息,结构化数据可能与问题相关。参与者使用模拟API,输入从问题中派生的参数,以检索相关数据用于答案制定。评估重点是系统查询结构化数据和将信息从各种来源整合到全面答案的能力。

任务3:端到端RAG

第三个任务通过为每个问题提供50个网页和模拟API访问,遇到相关信息和噪音,增加了复杂性。它评估了系统从更大数据集中选择最重要数据的能力,反映了真实世界信息检索和整合的挑战。

评价指标

RAG系统使用一种评分方法进行评估,该方法衡量了对评估集中问题的响应质量。响应被评定为完美、可接受、缺失或不正确:

- 完美:响应正确回答用户问题,并且不包含幻觉内容。

- 可接受:响应提供了对用户问题的有用答案,但可能包含轻微错误,不影响答案的有用性。

- 缺失:答案没有提供请求的信息。例如,“我不知道”,“很抱歉,我找不到……”或类似的句子,没有提供问题的具体答案。

- 不正确:响应提供错误或不相关的信息来回答用户问题。

分数如下所示:完美 = 1 分,可接受 = 0.5 分,缺失 = 0 分,不正确 = -1 分。总体得分是对所有领域的宏平均,根据类型受欢迎程度和实体受欢迎程度加权(权重将不会公开)。

赛题时间轴

挑战将分为两个阶段。第一阶段将向所有报名的团队开放。根据参与人数,第一阶段结束后,我们可能会设置一个截止日期,将第二阶段限制为仅限排名靠前的团队。

第一阶段:公开竞赛

- 网站开放,数据可用,和注册开始日期: 2024年3月20日,23:55 UTC

- 第一阶段提交开始日期: 2024年4月1日,23:55 UTC

- 第一阶段提交截止日期: 2024年5月20日,23:55 UTC

第二阶段:排名靠前团队的比赛

- 第二阶段开始日期: 2024年5月22日,23:55 UTC

- 注册和团队冻结截止日期: 2024年5月31日,23:55 UTC

- 第二阶段结束日期: 2024年6月20日,23:55 UTC

获奖者公布

- 获奖者通知日期: 2024年7月15日

- 获奖者公开公告日期: 2024年8月26日(在KDD杯获奖者活动上)

赛题奖金

该挑战拥有总奖池 31,500美元。每个任务都设有奖金。对于每个任务,以下团队将获得现金奖励:

第一名: 4,000美元

第一名: 4,000美元 第二名: 2,000美元

第二名: 2,000美元 第三名: 1,000美元

第三名: 1,000美元 每个复杂问题类型的第一名: 500美元

每个复杂问题类型的第一名: 500美元

第一、第二和第三名的获奖者不具备基于相同任务中的复杂问题类型获得奖金的资格。