- 赛题名称:CVPR 2024 Workshop 面向视觉大模型的对抗攻击竞赛

- 赛题类型:计算机视觉、对抗样本

赛题背景

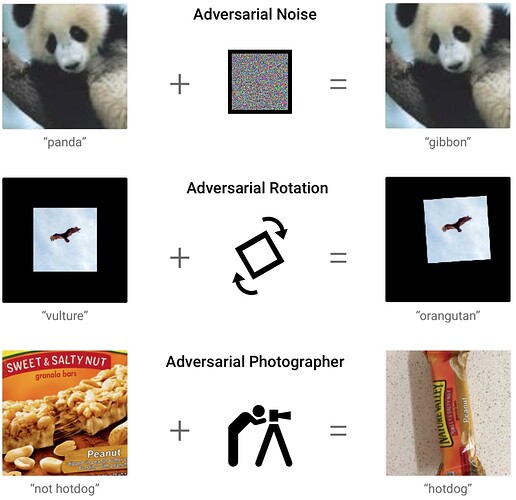

随着基础模型(Foundation Models, FMs)的出现,人工智能(AI)已经进入了一个新的时代。这些模型通过利用大量的模型参数和训练数据,展现出了强大的生成能力,它们在计算机视觉领域成为了主导力量,彻底改变了广泛的应用场景。然而,随着对基础模型依赖性的增加,它们的安全性问题也暴露出来,特别是对对抗性攻击的脆弱性。

对抗性攻击是指通过在输入图像或提示中施加难以察觉的扰动,导致模型误分类对象或生成攻击者预期的输出。这种脆弱性在安全关键的应用中,如自动驾驶车辆和医疗诊断,可能带来重大风险,因为在这些领域中,错误的预测可能会产生严重的后果。

本次大赛依托CVPR 2024的workshop“The 4th Workshop of Adversarial Machine Learning on Computer Vision: Robustness of Foundation Models”展开,希望鼓励研究者开发面向视觉大模型的黑盒对抗攻击算法,以自动驾驶作为典型应用场景,在复杂的真实世界场景及未知的大模型结构等因素下,探究视觉大模型的安全风险,促进鲁棒视觉大模型的发展。

赛题任务:多任务对抗评测

这次的视觉大模型黑盒对抗攻击比赛分为两个阶段。

Phase 1:开源大模型白盒对抗攻击

初赛阶段,比赛会释放数据集,参赛者可以使用数据集或其他任何数据集,以及任何模型训练攻击算法。数据集中的攻击目标类别包含行人、车辆、交通牌等共5类。

初赛的攻击目标包含2个开源大模型、3个大模型任务。通过对数据集中的图像应用对抗攻击,选手需要得到足够鲁棒的对抗样本,能够干扰大模型的颜色判断、目标分类与统计计数三个任务的输出结果。初赛阶段选手需要将使用给定数据集生成的对抗样本提交。

Phase 2:闭源大模型黑盒对抗攻击

复赛阶段,参赛者同样可以使用释放的数据集或其他任何数据集,以及任何模型训练攻击算法。但与初赛不同的是,复赛的待攻击模型将额外引入2个闭源大模型,对于所设计对抗攻击算法的迁移性与鲁棒性有着更高的要求。

比赛时间

3月22日-5月10日

比赛奖励

- 冠军团队将获得新加坡A*STAR公司的2名实习offer

- 前十名将授予证书

前8名将根据名次获得奖金,其中第一名可获得超过1000美元的奖金;前3名将获得共计价值2万元人民币的云计算资源。

比赛链接

比赛官网:

https://challenge.aisafety.org.cn

Workshop地址:

https://cvpr24-advml.github.io/

北航刘祥龙教授团队介绍:

xlliu-beihang.github.io